NEIN, zumindest meinen das Apple Forscher auf den ersten Blick mit The Illusion of Thinking, und das ist Wasser auf die Mühlen der KI-Skeptiker. Oder ists bloss das schlecht Machen der KI von einer Firma, die in diesem Bereich zu wenig weiter bringt? Hier meine (ak) Meinung dazu (1).

Was ist KI-Nachdenken?

Die traditionelle KI antwortet spontan, ohne Nachdenk-Überlegung – sie produziert direkt ihre einzelnen Antwort-Token, passend zum aktuellen Kontext.

Hingegen produziert die neue “Nachdenk”-KI (reasoning AI, wie beispielsweise openAI o1/o3, DeepSeek R1, Claude 3.7 Sonnet+thinking) zunächst einmal einen (zumeist verborgenen) inneren Monolog an “Nachdenk”/”Thinking” Token, und erst danach die eigenen Antwort-Token. Dies erhöht die Qualität der Antwort für kompliziertere Probleme dramatisch.

Ein praktisches Beispiel: Was ist 36+59? – die meisten Menschen können hier nicht spontan antworten, sie addieren gedanklich zuerst die Einer, und dann den Übertrag zu den Zehnern, und antworten erst dann mit 95. Eine traditionelle KI kann das auch meist nicht direkt beantworten (außer sie hat ein neuartiges Schätzverfahren gelernt, wie die meiste neue und gute KI). Ein “Nachdenk” KI-Modell produziert zuerst den (verborgenen) “Nachdenk”/”thinking” Text, z.B. 30+50=80, plus 6+9=15 equals 95. und dann eben die Antwort 95.

Gute “Nachdenk”-KI produziert wenig und präzises internes Nachdenken, schlechtere KI neigt oft zum “over-thinking”. Aber diese Art von “Nachdenken” ist aufwändig, deshalb limitieren die meisten KI-Anbieter die Menge von Token, die eine KI zum “Nachdenken” verwenden kann. Und diese KI gibt damit auch auf, wenn sie mit ihrem “Nachdenk”-Budget keine gute Antwortstrategie zusammenbringt.

Die Apple Publikation

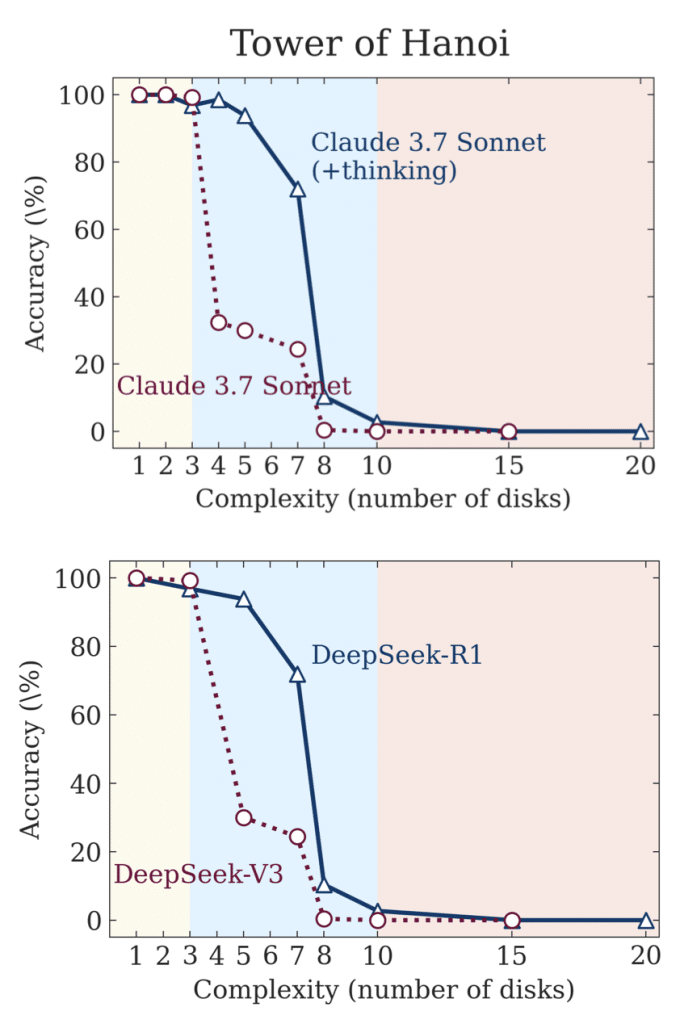

Die Apple-Forscher haben untersucht, ab welcher Problemkomplexität die KI keine Lösung liefert, d.h. das Nachdenken scheitert.

Allerdings ist dieses Aufgeben der KI durchaus ähnlich zum Menschen. Ich gebe auch bei komplexen Problemen auf, diverse Zeugnisse bestätigen aber, dass ich ein geprüfter Nachdenkender bin.

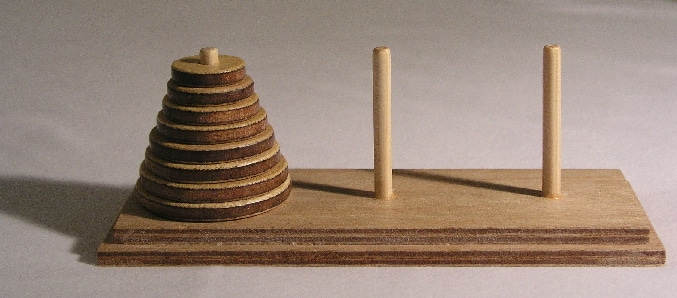

Womit haben die Apple-Forscher die KI geprüft? Sie wollten keine Problemstellungen, bei denen die Lösung oder der Lösungsansatz irgendwie im Lernmaterial der KI war. Damit sie die Lösung nicht auswendig gelernt hat, und damit antworten kann. Sie haben damit mathematische Denksportaufgaben gewählt, beispielsweise die bekannten “Türme von Hanoi“.

Ok, die Resultate: Sie haben gemessen, mit wie vielen Scheiben im Rätsel die KI das korrekte Ergebnis produzieren konnte. Mit Claude 3.7 Sonnet und Deepseek R1/V1 – jeweils der klassischen (bei DeepSeek ist das V3) und der “Nachdenk”/”+thinking” Version (bei DeepSeek R1).

D.h. die klassischen KI-Modelle stehen mit dem Auswendiglernen bei 4 und mehr Scheiben an, die “Nachdenk”-KI bei Lösungen für 8 und mehr.

KI-“Nachdenken”?

Bedeutet das – für mich – daß Claude 3.7 Sonnet (+thinking) bzw. DeepSeek R1 nicht nachdenken können? NEIN, sie geben bloss bei zu komplexen Problemen auf!

Die Anzahl der Lösungsschritte für die Türme von Hanoi ist 2^n -1. Bei 8 wären das daher 255 Schritte. Die Wahrscheinlichkeit, daß ich selber diese 255 Schritte ohne Fehler zusammenbringe ist für mich zu klein, um es anzugehen. Ich hätte sogar eher, bei n=5 d.h. 31 Schritten, aufgegeben. Die “Nachdenk”-KI hat ein angelerntes Budgetlimit für die “Nachdenk”-Token, und dies würde damit überschritten, das “Nachdenken” zu lange dauern. Sie gibt daher auf.

Die Quintessenz: Das Apple-Paper zeigt auf, dass Probleme am Besten in 3 Klassen unterteilt werden sollten: 1) einfache – hier funktioniert die klassische KI am besten, 2) mittlere – hier liefert die “Nachdenk”-KI die besten Ergebnisse, 3) schwere – hier gibt die KI oft auf. Aber nach meiner Erfahrung liefert die KI auch hier gute Ideen als Ergebnisse, wenn man sie eben nach der Vorgehensweise statt dem Ergebnis fragt. Dazu z.B. OpenAI 4os Vorschlag für eine Türme von Hanoi Lösung in Python – und das, ohne “nachdzudenken”:

def hanoi(n, source, target, auxiliary):

if n == 1:

print(f"Move disk 1 from {source} to {target}")

else:

hanoi(n - 1, source, auxiliary, target)

print(f"Move disk {n} from {source} to {target}")

hanoi(n - 1, auxiliary, target, source)

# To solve for 8 disks:

hanoi(8, 'A', 'C', 'B')Der Ausblick: Für mich ist die KI im Nachdenken gut genug, wenn sie Spitzen-Mathematiker mit ihre Resultaten verblüfft. Oder sie mir diese Woche half, gemeinsam knifflige Linux-Probleme zu lösen – Probleme, bei denen ich mit meinen menschlichen Nachdenkfähigkeiten angestanden bin. Neue Modelle wie beispielsweise das Anfang Juni 2025 vorgestellte openAI O4 Pro haben zusätzlich größere “Nachdenk”-Limits und sie können auch selbst gut Werkzeuge verwenden – z.B. selbst geschriebenen Python-Code direkt ausführen.

(1) Meine Meinung ist stark beeinflusst von Nathan Lambert: The rise of reasoning machines

- Über den Autor

- Artikel

Informatiker, Marketer und Fotograf. Versucht Funktion, Nutzen und Risken komplexer Informationstechnologie verständlich darzustellen. Arbeitete in lokalen und internationalen Rollen, beispielsweise als Geschäftsfeldleiter bei Microsoft. Windows/MacOS/Linux KI-Enthusiast.

Neueste Kommentare